はじめに

遅くなりましたが、明けましておめでとうございます。nikkieです。

本年もアウトプットを継続していきます。

今回は「みんなのPython勉強会#31」にお邪魔してきました。

2018/01/24 勉強会の資料を追加しました。

勉強会の概要

概要

「みんなのPython勉強会」では、Pythonを中心としてプログラミングを仕事、研究、趣味など様々なシーンに生かす方法を一緒に学びます。プログラマ、WEBエンジニアに限らず、初心者からマスターまで様々なレベルの、いろいろな分野の人が集まるので、「みんな」の勉強会です。お気軽にご参加ください。

31回のテーマは「オープンソースを武器にする」だそうです。

勉強会プログラム

「Pythonでスタートして、Pythonを仕事にするまでの話」

「量子コンピュータプログラミング入門」

「pythonと人工知能」

Pythonを書いて食べていきたいと最近夢想しているので

「Pythonでスタートして、Pythonを仕事にするまでの話」を楽しみに参加しました。

以下、講演中のメモをもとに振り返ります。

「Pythonでスタートして、Pythonを仕事にするまでの話」

「火を焚べ続けるのに必要な3つのこと」のうち素振りの話が特に印象に残りました。実践していきます。

・興味があったらすかさず手を挙げる

・チャンスを逃さないために日頃から素振り

・Pythonへの興味と情熱

以下講演内で興味をひいたトピックです。()は私の感想です。

・コードが書けるエンジニアになりたい(ほんとそれ!)

・LT駆動開発(#stapyはLTしやすそうな雰囲気でした。次回狙ってみます)

・仕事探しでPyConJPのスポンサーをチェック(なるほど)

・コミュニティに入ると技術に対してアンテナを張れる、かつ、エンジニアと繋がれる(本当に一石二鳥)

「量子コンピュータプログラミング入門」

量子コンピュータは全く追えていない分野だったのですが、

IBM Qなら無料で使うことができるというので少し身近に感じました。

IBM Quantum Computing で計算してみよう

学習ツールの一つとして紹介されたQiitaのアドベントカレンダーを見ると、

少しキャッチアップできそうです。

量子コンピュータ Advent Calendar 2017 - Qiita

「pythonと人工知能」

機械学習をここ最近勉強しているため、勉強前と比べて理解できる部分が増えてきた実感があります。(と言ってもまだまだですが。。)

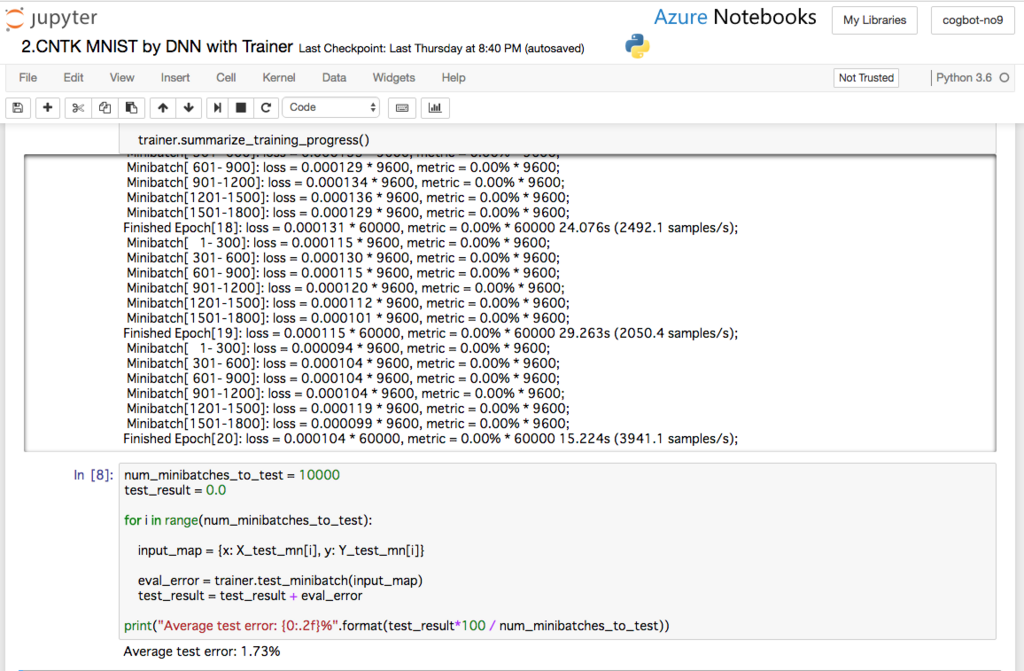

・分類:CNN(画像解析)、RNN(時系列解析)、DQN(自動運転、ゲーム)、GAN(キャラクタ生成)

・Deep Learningの他にSVMなど機械学習のモデルを並列で用意して出力のいいところどりをするアンサンブル学習

・文章に対して「政治」「スポーツ」のようなジャンル分けをDeep Learningで行う場合、各ジャンル1万文の学習データが必要

興味深かったLT

ツイッターのリツイートをトリガーにして、読むべき論文のPDFをIssueに登録する自動化LTは

GitHubのIssueをTODOリストとして使うという発想に感服しました。

他にはWindowsで環境構築するLTもありました。

終わりに

Pythonで集まったところ、量子コンピュータや機械学習まで話が広がる会で

すごいコミュニティだ、継続して参加していきたいと感じました。

講演者・勉強会関係者の皆さま、並びに出席者の皆様、どうもありがとうございました。

資料はアップされるそうなので、確認次第更新します。